Система искусственного интеллекта AlphaGo одержала третью и окончательную победу над чемпионом мира по игре Го - «Наука и технологии»

Специализированная система искусственного интеллекта AlphaGo, разработанная и обученная специалистами подразделения компании Google DeepMind, одержала третью окончательную победу над 18-кратным чемпионом мира по древней китайской игре Го Ли Седолем (Lee Sedol). Первую победу система одержала после

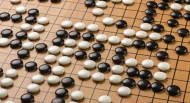

Специализированная система искусственного интеллекта AlphaGo, разработанная и обученная специалистами подразделения компании Google DeepMind, одержала третью окончательную победу над 18-кратным чемпионом мира по древней китайской игре Го Ли Седолем (Lee Sedol). Первую победу система одержала после 186 ходов во время матча, проводившегося в среду прошлой недели, а для достижения второй победы в четверг системе AlphaGo пришлось сделать 211 ходов. Третья кряду победа уже делает систему AlphaGo безусловным победителем, хотя два оставшихся матча будут сыграны "ради спортивного интереса".

За победу над чемпионом мира Google DeepMind получит вознаграждение в 1 миллион долларов, которое полностью будет пожертвовано на благотворительность. Ведь целью компании Google не являлось именно получение вознаграждения, система искусственного интеллекта разрабатывалась чисто в практических целях, для ее использования во многих сервисах и приложениях, включая поиск, которые после этого обретут массу новых функций и возможностей.

Игра Го является "крепким орешком" для машинных алгоритмов из-за ее сложности. В ней используется доска, размером 19 на 19 клеток, а число вариантов развития событий исчисляется триллионами триллионов. Для того, чтобы одержать победу над человеком, программисты DeepMind создали цифровую виртуальную нейронную сеть и обучили ее на примерах более 30 миллионов ходов из разных партий. Далее система стала совершенствовать сама себя, играя сама с собой многие миллионы раз. Такой подход кардинально отличается от принципов, на которых была основана система Deep Blue компании IBM, которая в 1997 году сражалась в шахматы с Гарри Каспаровым.

Несмотря на нынешнее успешное выступление системы AlphaGo, подобные системы искусственного интеллекта еще не до конца готовы к их практическому применению. Согласно прогнозам специалистов компании Google, момент, когда искусственный интеллект начнет действительно работать, наступит не раньше, чем через пять лет. А дальнейшие усилия специалистов DeepMind будут следовать идее, что если систему искусственного интеллекта обучить хорошо выполнять некие действия в условиях виртуальной реальности и компьютерных игр, то она также хорошо сможет действовать и в условиях реального окружающего мира.

Согласно имеющейся информации, игра Го стала первой и последней настольной игрой, на которой были сосредоточены их усилия. Демис Хассабис (Demis Hassabis), основатель и руководитель подразделения DeepMind, упомянул об известной компьютерной игре StarCraft, как о следующем "поле деятельности" их систем искусственного интеллекта, которое чуть более приближено к реальности и которое предоставит искусственному интеллекту более широкий выбор выполняемых действий.

Подпишитесь

И будьте в курсе первыми!

И будьте в курсе первыми!

Минимальная длина комментария - 50 знаков. комментарии модерируются

Смотрите также

из категории "Технологии"

barilline.ru

barilline.ru